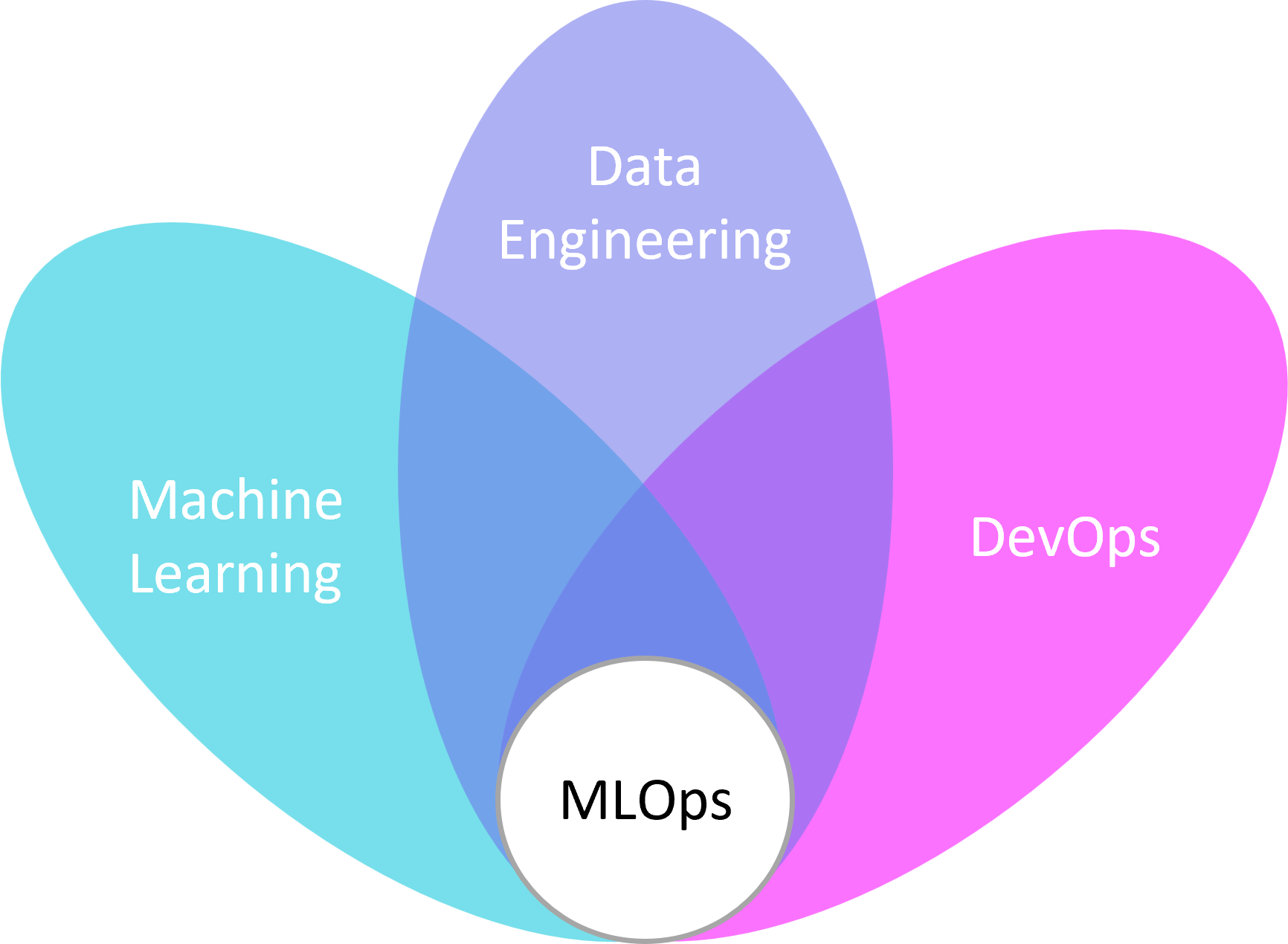

L'IA n'est plus exclusivement réservée aux entreprises natives du numérique ! Elle s'intègre dans les produits et les processus de pratiquement tous les secteurs, mais sa mise en œuvre à grande échelle reste un problème non résolu et frustrant pour la plupart des organisations. Les entreprises peuvent assurer le succès de leurs efforts en matière d'IA en mettant à l'échelle les équipes, les processus et les outils d'une manière intégrée et cohérente. Cela fait partie d'une discipline émergente appelée MLOps, ou opérationnalisation du machine learning. Il semble naturel de penser que la DSI a un rôle à jouer et qu’elle devrait être au cœur de la stratégie et de l'évolution de cette mise à l’échelle MLOps.

Face à la complexité du passage de l’expérimentation à l’opérationnalisation de l’intelligence artificielle, le constat révèle que la majorité des entreprises ont du mal à passer à l’échelle. En effet, la valeur de ses cas d’usages est souvent difficile à quantifier, les délais de développement sont longs et le déploiement des modèles est complexe car il implique des métiers qui ne parlent pas la même langue : des métiers différents qui ont des

compétences différentes et qui utilisent des outils différents, de quoi se dire que le problème ne revient pas qu’à l’IA mais aussi à la structure organisationnelle. Les DSI et les organisations sont de plus en plus confrontées à l’omniprésence de l’apprentissage automatique et à la complexité du cycle de vie de ses projets, le MLOps répond à ces problématiques en étant une discipline qui vise à réunir un ensemble de pratiques, de savoir-faire et finalement de culture.

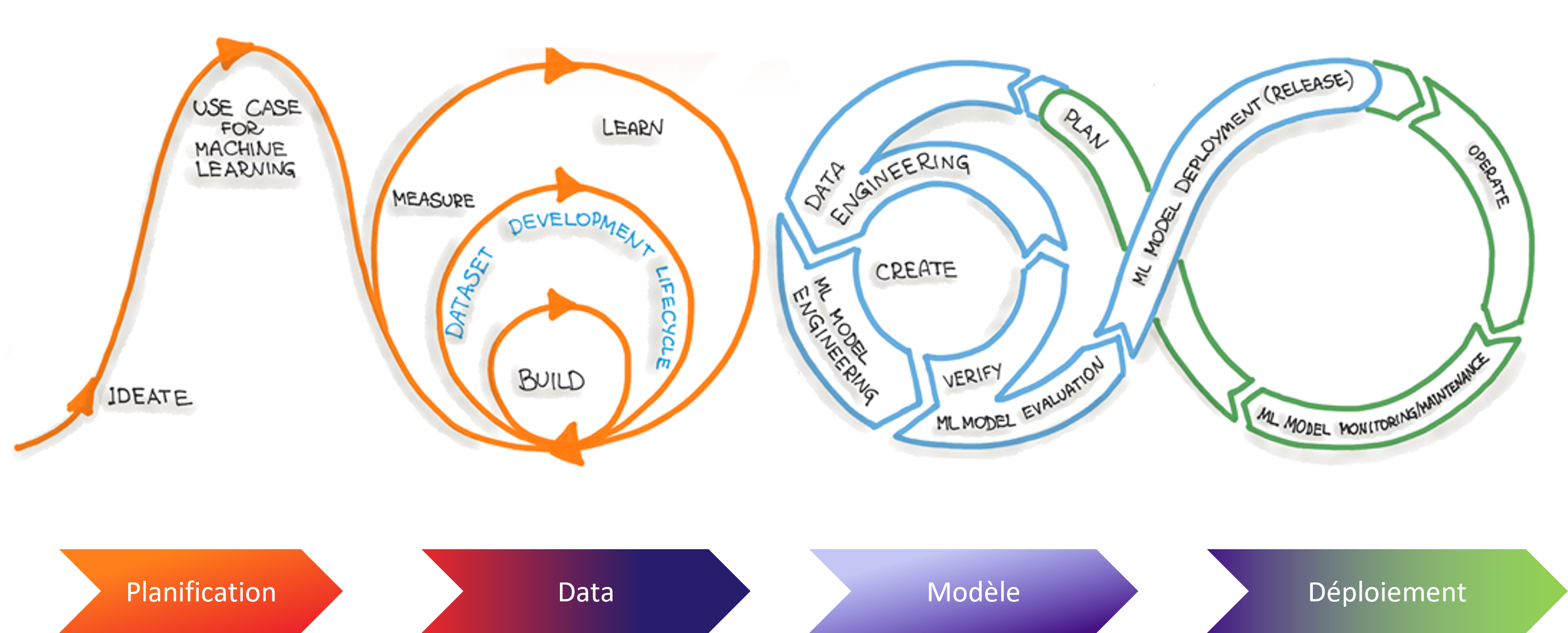

Construire des modèles alimentés en IA est un processus créatif qui nécessite itérations et raffinements constants

Une IA est plus utile et maitrisée lorsqu’elle est opérationnalisée sur toute l’étendue

de la chaîne de valeur. Tant que les modèles ne sont pas mis en production, la

valeur d’un projet en intelligence artificielle ne peut jamais totalement être

démontrée.

Les différents points de convergence

Le MLOps est-il si indispensable aujourd'hui ?

Le MLOps est-il si indispensable aujourd'hui ?

Face à la complexité de mise en œuvre des cas d’usages en IA, les défis à relever par les organisations pour évoluer et s’adapter sont bien d’actualité. Le curseur d’adoption est à placer en fonction de leurs tailles et des moyens, mais avec une mise à l’échelle les problèmes se mettent aussi à « scaler ». Avant de parler et d’intégrer le MLOps dans son organisation, il faut d’abord avoir pensé et s’être assuré de la mise en œuvre d’une stratégie data qui doit être au coeur de l’organisation (data quality, gouvernance, etc.). Parmi les DSI interrogés, il y a eu un vrai consensus sur l’utilité du MLOps de nos jours mais seulement lorsqu’il existe une culture data dans l’organisation.

Les personnes et la structure organisationnelle, le nerf de la guerre ?

Le développement de l'IA relevait auparavant de la responsabilité d'une équipe IA, mais la construction de l'apprentissage automatique à grande échelle ne peut pas être produite par une seule équipe. Elle nécessite une

variété de compétences uniques, et très peu d'individus les possèdent toutes. Pour faire évoluer l'IA avec succès, les organisations doivent constituer et responsabiliser des équipes qui peuvent se concentrer sur des priorités stratégiques de grande valeur que seules leurs équipes peut accomplir. Laissez les data scientists faire de la data science, laissez les ingénieurs faire l’ingénierie, laissez l'informatique se concentrer sur l’intégration et l'infrastructure .

Normaliser les processus, pourquoi ?

La première étape pour faire évoluer l'IA est la normalisation : un moyen de créer des modèles de manière reproductible et un processus bien défini pour les opérationnaliser. Les processus sur mesure sont (par nature) pleins d'inefficacité. Pourtant, de nombreuses organisations tombent dans le piège de réinventer la roue chaque fois qu'elles opérationnalisent un modèle. Pour normaliser, les organisations doivent définir en collaboration un processus « recommandé » pour le développement et l'opérationnalisation de l'IA, et fournir des outils pour

soutenir l'adoption de ce processus. Les catalogues de data, de modèles et les feature stores peuvent prendre en charge cette standardisation.

En 2022, est-il si facile de choisir une plate-forme MLOps ?

Étant donné qu'essayer de standardiser la production d'IA et de ML est un projet relativement nouveau, l'écosystème des outils de science des données et d'apprentissage automatique reste très fragmenté, un puzzle

à 1000 pièces ! Pour construire un unique modèle, un data scientist travaille avec environ une douzaine d'outils spécialisés. D'un autre côté, l'IT ou la gouvernance utilise un ensemble d'outils complètement différents, et ces chaînes d'outils distinctes ne communiquent pas facilement entre elles. Par conséquent, il est facile de collaborer ponctuellement, mais il est difficile de créer un flux de travail robuste et reproductible. Une collection dispersée d'outils peut entraîner de longs délais de commercialisation et la construction de produits d'IA sans surveillance adéquate, d’où l’importance des plateformes end-to-end.

Parmi, les outils existants dans l‘univers du MLOps, on retrouve :

- Cloud : des outils précurseurs répondant à des problématiques similaires et qui se démocratisent au sein des organisations.

- Amazon Sagemaker : une plateforme ML qui vous aide à construire, former, gérer et déployer des modèles d'apprentissage automatique dans un environnement ML prêt pour la production.

- Azure Machine Learning : tout comme SageMaker, il prend en charge l'apprentissage supervisé et non supervisé.

- Google Cloud Vertex AI : une plateforme entièrement gérée de bout en bout pour l’apprentissage automatique et la science des données. Elle dispose de fonctionnalités qui aident à gérer les services de manière transparente. Leur workflow ML facilite les choses pour les développeurs, les data scientists et engineers.

Autres outils notables :

- MLflow : plateforme open-source permettant de contrôler les workflows des pipelines d'apprentissage automatique. Elle prend en charge l'expérimentation, la reproductibilité et le déploiement.

- Domino Data Lab : très prisée des équipes qui se concentrent sur la gestion des données, notamment parce qu'elle se concentre sur la création d'espaces de stockage et de visualisation centralisés pour les données MLOps.

- Metaflow (Netflix) : aide à concevoir un flux de travail, à l’exécuter à l’échelle et à le déployer en production.

- HPE Ezmeral, Iguazio, Paperspace, etc.

Les points d’attention pour le succès d’une stratégie MLOps

- L’interopérabilité : Assurez-vous que les nouveaux outils fonctionneront avec l'écosystème IT existant ou pourront être facilement étendus. Pour les organisations passant d'une infrastructure on prem au cloud, recherchez des outils qui fonctionneront dans un environnement hybride, car la migration vers le cloud prend souvent plusieurs années.

- La convivialité entre l’IT et les équipes IA : ceux-ci ont tendance à avoir des besoins opposés. La plate-forme pressentie doit offrir de la flexibilité aux data scientists pour utiliser les bibliothèques de leur choix et travailler de manière indépendante sans nécessiter une assistance technique constante. D'autre part, l’IT a besoin d'une plate-forme qui impose des contraintes et garantit que les déploiements de production suivent des chemins prédéfinis et approuvés. Une plate-forme MLOps bien pensée peut faire les deux.

- La collaboration : un outil MLOps doit permettre aux data scientists de travailler facilement avec les data engineer et vice versa, et de travailler avec la gouvernance et la conformité. Le partage des connaissances et la garantie de la continuité des activités face au roulement des collaborateurs sont cruciaux.

- La gouvernance : Avec l'IA, la gouvernance devient beaucoup plus critique que dans d'autres applications. Elle est chargée de s'assurer qu'une application est alignée sur la charte de code éthique d'une organisation, que l'application n'est pas biaisée en faveur d'un groupe protégé et que les décisions prises par l'application d'IA sont fiables. Selon les situations (l’existant, la culture et la maturité, les budgets, la taille de l’organisation, etc.) plusieurs options existent. Au travers de son accompagnement, Aneo est justement là pour prendre en compte ces différentes situations et pour aider à prendre le meilleur choix.

Sommes-nous en pénurie de (bons) profils ?

La mise en production d'un ou deux modèles d'IA est très différente de la gestion d'un produit entier sur l'IA et trouver des profils capables de prendre du recul sur ce point est une véritable force. Malgré cela, trouver des profils IA n’est plus un problème, il n’y a qu’à voir le nombre de masters qui fleurissent dans le milieu universitaire, mais trouver des profils polyvalents, cela se relève être plus compliqué…

Les tendances exprimées par les DSI présents

- La pénurie de talents reste endémique

- Pour tirer parti des outils, il faut accroître la consolidation autour des plateformes end-to-end

- L’adoption culturelle de la pensée ML par l’IT est stratégique pour opérationnaliser l’IA

Les dirigeants recherchent toujours des moyens de prendre une longueur d'avance et de créer plus de valeur grâce à l’intelligence artificielle. Malgré tout, les entreprises avec les meilleurs modèles ou les data scientist les plus intelligents ne sont pas nécessairement celles qui vont s’imposer : le succès ira aux entreprises qui peuvent

mettre en œuvre et évoluer intelligemment pour libérer tout le potentiel de l'IA.